Por Erick Cortés.- Con el fin de regular el uso e identificar el contenido generado por inteligencia artificial, la empresa Meta anunció que informará a sus usuarios cuáles de las imágenes que se publiquen en Facebook, Instagram y Threads hayan sido creadas con esta tecnología.

El presidente de Asuntos Globales de Meta, Nick Clegg, dijo que esta medida busca facilitar la distinción entre imágenes creadas por algoritmos y aquellas capturadas de la realidad, algo que considera necesario ante la creciente presencia y el continuo avance de las inteligencias artificiales, capaces de crear imágenes cada vez más realistas.

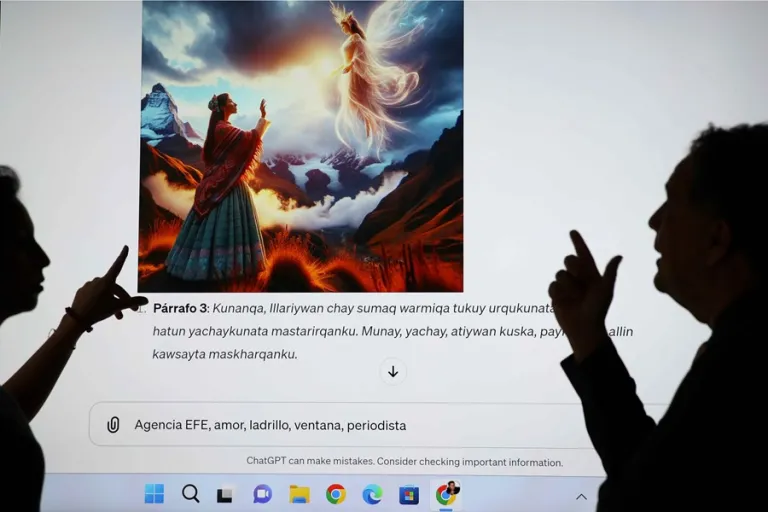

“En los próximos meses etiquetaremos las imágenes que los usuarios publiquen, siempre y cuando podamos detectar los indicadores, conformes a las normas de la industria, que revelen que son generadas por IA”, anunció Clegg.

La etiqueta tendrá la denominación “Imaginado con IA”, pero aparecerá sólo en aquellas imágenes que hayan sido creadas con la herramienta Meta AI, de la propia empresa, aunque Clegg señaló que ya se está trabajando en el desarrollo de herramientas para identificar y etiquetar imágenes generadas por otras empresas, como OpenAI, Google, Dall-E, Midjourney y Adobe.

“No es perfecta, la tecnología aún no está completamente desarrollada, pero es el intento más avanzado hasta ahora para proporcionar transparencia de forma significativa a miles de millones de personas en todo el mundo”, dijo.

Por su parte, la empresa OpenAI, creadora de Chat GPT, también anunció que lanzará herramientas para combatir la desinformación y afirmó que no permitirá que su tecnología sea usada con fines políticos.

Si bien ambas empresas reconocen que sus nuevas medidas no eliminarán totalmente el riesgo de que se produzcan noticias e información falsas, se han propuesto minimizar su proliferación.

Meta, por ejemplo, también planea implementar una función en Facebook que permitirá a los usuarios saber cuando compartan un video, foto o audio generado por inteligencia artificial, lo que reducirá el riesgo de que el usuario comparta imágenes e información falsas sin saberlo.

Como medida adicional, la compañía de Zuckerberg también se plantea comenzar a exigir a sus usuarios revelar cuando realicen publicaciones con contenido multimedia generado por IA, para no ser sancionados por la plataforma del mismo modo que ya se amonesta a las cuentas que comparten contenido que viola las normas de la comunidad.

Con el fin de regular el uso e identificar el contenido generado por inteligencia artificial, la empresa Meta anunció que informará a sus usuarios cuáles de las imágenes que se publiquen en Facebook, Instagram y Threads hayan sido creadas con esta tecnología.

El presidente de Asuntos Globales de Meta, Nick Clegg, dijo que esta medida busca facilitar la distinción entre imágenes creadas por algoritmos y aquellas capturadas de la realidad, algo que considera necesario ante la creciente presencia y el continuo avance las inteligencias artificiales, capaces de crear imágenes cada vez más realistas.

“En los próximos meses etiquetaremos las imágenes que los usuarios publiquen, siempre y cuando podamos detectar los indicadores, conformes a las normas de la industria, que revelen que son generadas por IA”, anunció Clegg.

La etiqueta tendrá la denominación “Imaginado con IA”, pero aparecerá sólo en aquellas imágenes que hayan sido creadas con la herramienta Meta AI, de la propia empresa, aunque Clegg señaló que ya se está trabajando en el desarrollo de herramientas para identificar y etiquetar imágenes generadas por otras empresas, como OpenAI, Google, Dall-E, Midjourney y Adobe.

“No es perfecta, la tecnología aún no está completamente desarrollada, pero es el intento más avanzado hasta ahora para proporcionar transparencia de forma significativa a miles de millones de personas en todo el mundo”, dijo.

Por su parte, la empresa OpenAI, creadora de Chat GPT, también anunció que lanzará herramientas para combatir la desinformación y afirmó que no permitirá que su tecnología sea usada con fines políticos.

Si bien ambas empresas reconocen que sus nuevas medidas no eliminarán totalmente el riesgo de que se produzcan noticias e información falsa, se han propuesto minimizar su proliferación.

Meta, por ejemplo, también planea implementar una función en Facebook que permitirá a los usuarios saber cuando compartan un video, foto o audio generado por inteligencia artificial, lo que reducirá el riesgo de que las personas compartan imágenes e información falsas sin saberlo.

Como medida adicional, la compañía de Zuckerberg también se plantea comenzar a exigir a sus usuarios revelar cuando realicen publicaciones con contenido multimedia generado por IA, para no ser sancionados por la plataforma del mismo modo que ya se amonesta a las cuentas que comparten contenido que viola las normas de la comunidad.